목록분류 전체보기 (49)

ufris

docker에서 anaconda 설치

docker에서 anaconda 설치

docker 안에서는 인터넷을 통해 다운 받는게 어렵기 때문에 wget으로 설치 파일을 다운 받습니다 anaconda 사이트에서 다운 받으려는 설치 파일 우클릭으로 '주소 복사'를 해서 $ wget https://repo.anaconda.com/archive/Anaconda3-2023.09-0-Linux-x86_64.sh 를 통해 다운을 받습니다 https://ufris.tistory.com/5 ubuntu에서 pycharm과 anaconda 설치 및 가상환경 만들기 pycharm 설치 터미널에서 아래 코드를 실행합니다 sudo apt install snapd snapd-xdg-opensudo snap install pycharm-community --classic Anaconda 설치 아나콘다를 설치하..

docker에서 jupyter notebook 실행 후 conda kernel 설정 및 외부접속

docker에서 jupyter notebook 실행 후 conda kernel 설정 및 외부접속

docker에서 jupyter notebook을 실행해서 외부에서 접속하기 전에 docker container에 포트를 설정해야 합니다 container를 만들 때 -p를 통해 포트 번호를 설정해줍니다 $ docker run -it -p 8888:8888 --name ubuntu_test ubuntu:18.04 /bin/bash jupyter 설치 $ pip install jupyter notebook ipywidgets jupyterlab jupyter notebook 실행 $ jupyter notebook --ip 0.0.0.0 --allow-root 를 통해 모든 ip에 대한 접속을 허용합니다 창에 뜨는 주소를 crtl + 클릭을 통해 jupyter에 접속하면 됩니다 conda 가상환경을 jupyt..

docker container를 image로 생성

docker container를 image로 생성

기본 ubuntu docker image를 통해 container를 만들어 apt를 설치하고 세팅을 설정한 다음 동일한 ubuntu docker로 container를 만들면 똑같은 세팅을 반복해야합니다 (가장 기본적인 wget, vim, net-tools 등등) 이러한 반복 작업을 하지 않기 위해서 docker container를 docker image로 만들어서 관리하면 편합니다 $ docker ps -a 를 통해 image로 만들 container의 container ID 를 확인합니다 $ docker commit f836f7b23461(=CONTAINER ID) jupyter(=image 이름) 를 통해 container를 image로 만듭니다 $ docker images 를 통해 확인 가능합니다

docker ubuntu 18.04 이미지로 설치

docker ubuntu 18.04 이미지로 설치

docker 이미지로 ubuntu 18.04 설치 및 실행하는 법 - ubuntu 18.04 docker 이미지 다운 $ docker pull ubuntu:18.04 - local에 있는 도커 이미지 확인 $ docker images - ubuntu 18.04 이미지로 컨테이너 생성 $ docker run -it --name ubuntu_test ubuntu:18.04 /bin/bash 접속이 되면 root 로 들어가집니다 container에 port를 연결하려고 하면 $ docker run -it -p 80:80 --name ubuntu_test ubuntu:18.04 /bin/bash - docker 컨테이너 start, stop 및 실행 docker 실행하기 하기 위해서는 docker contain..

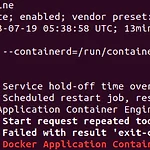

docker 설치 및 에러 해결

docker 설치 및 에러 해결

docker 설치 아래 코드는 docker 설치를 위한 세팅 부분 입니다 $ sudo apt update $ sudo apt install apt-transport-https ca-certificates curl software-properties-common $ curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add - $ sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu bionic stable" $ sudo apt update $ apt-cache policy docker-ce 마지막 코드를 입력하면 docker가 아직 설치..

conda나 pip으로 처음 설치를 하고 추후에 동일한 package를 설치할 때 기존에 설치된 package에 대한 cache 파일이 있어 다운로드 없이 기존에 있는 다운받은 package를 가져와서 깔게 됩니다 큰 문제는 없지만 이 cache 파일에 문제가 생기면 package들간에 꼬이는 현상이 발생합니다 이런 cache파일을 지우는 방법은 pip의 경우 $ pip cache purge conda의 경우 $ conda clean -all

https://towardsdatascience.com/medical-image-pre-processing-with-python-d07694852606 Medical Image Pre-Processing with Python An overview of preprocessing a dicom image for the training model. towardsdatascience.com https://vincentblog.xyz/posts/medical-images-in-python-computed-tomography

UMA node read from SysFS had negative value (-1)

UMA node read from SysFS had negative value (-1)

successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero gpu를 사용해 tensorflow를 돌릴 때 위와 같은 warning이 뜰 때가 있습니다 이에 대한 해결 방법은 우선 노드를 확인합니다 $ lspci | grep -i nvidia $ /sys/bus/pci/devices $ cat /sys/bus/pci/devices/0000\:06\:00.0/numa_node 빨간색 부분이 노드를 확인할 때 체크한 숫자와 매칭이 됩니다(빨간색 박스 부분) 노드와 연결이 되어 있지 않으면 -1로, 연결되어 있다면 0으로 프린트가 됩니다..

기존에 학습된 pretrained model의 weight을 사용해서 새로운 task를 학습하는 모델로 transfer learning을 진행할 때 pretrained model과 transfer learning을 진행하는 model간의 class 개수가 달라 weight이 정확히 매칭되지 않는다 문제가 발생합니다 이 문제를 해결하는 방법은 매치되는 weight만 적용시키는 것인데 pretrained model의 weight을 저장할 때 save_format을 tf가 아닌 h5형식으로 저장하는 것 입니다(model.save_weight(save_format='h5') 기존에 model.save_weight을 통해 weight을 저장하면 save_format이 tf로 되어 있는데 이 상태로 class 개수..

Loss와 Accuracy는 항상 반비례 관계인가

Loss와 Accuracy는 항상 반비례 관계인가

일반적으로 Loss가 낮으면 학습이 잘됐기 때문에 정확도도 높습니다 따라서 Loss가 낮아지면 정확도는 높아지는 반비례 관계라고 생각하게 됩니다 하지만 Loss가 낮다고 해서 항상 Accuracy가 높아지는 반비례 관계가 아닙니다 두가지 예시를 보시면 1. 정확도가 높은 경우의 Loss 위의 경우는 낮은 확률로 정답을 다 맞춘 경우입니다 정답은 다 맞췄기 때문에 정확도는 1.0을 찍었고 Loss는 0.895로 나왔습니다 2. 정확도는 낮지만 1번 경우와 비교해 Loss가 낮은 경우 위의 경우는 왼쪽은 높은 확률로 정답을 틀린 경우 오른쪽은 높은 확률로 정답을 맞춘 경우입니다 하나는 틀렸기 때문에 정확도는 0.5을 찍었고 Loss는 0.869가 나왔습니다 1번 경우와 비교했을 때 정확도는 낮지만 Loss는..